图像编辑赛道又迎来一次大升级!兔展智能携手北京大学 UniWorld 团队发布新一代图像编辑模型 ——UniWorld‑V2。它不仅在细节掌控上胜过 Nano Banana,对中文指令的理解也更加到位。

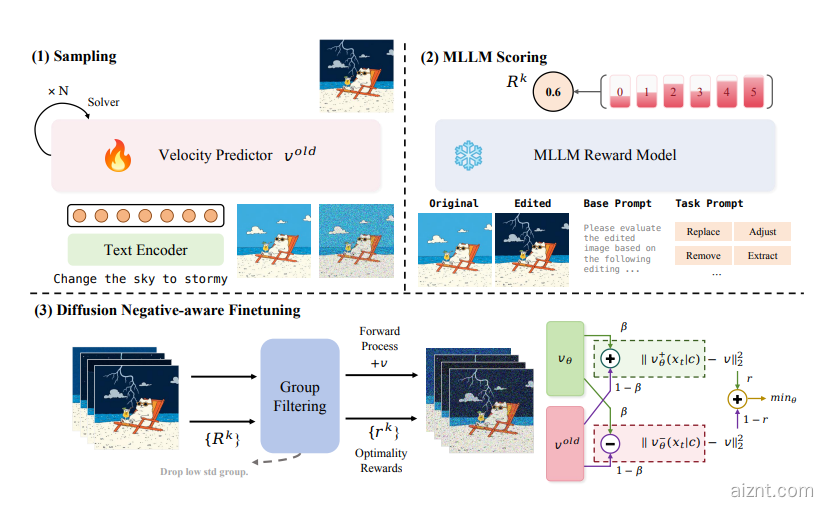

UniWorld‑V2 构建在全新的视觉强化学习框架 ——UniWorld‑R1 之上。该框架首次把强化学习中的策略优化引入图像编辑,显著提高了编辑的准确度与灵活度。相比传统的监督微调,UniWorld‑R1 旨在缓解过拟合、提升泛化,让模型面对多样化指令时响应更稳。

比如,用户让 AI 把女生的手势改成“OK”,UniWorld‑V2 能准确理解并完成;而 Nano Banana 没能正确把握意图。更亮眼的是,在海报场景中,UniWorld‑V2 可渲染复杂的中文艺术字,如“月满中秋”,清晰度与语义都到位。

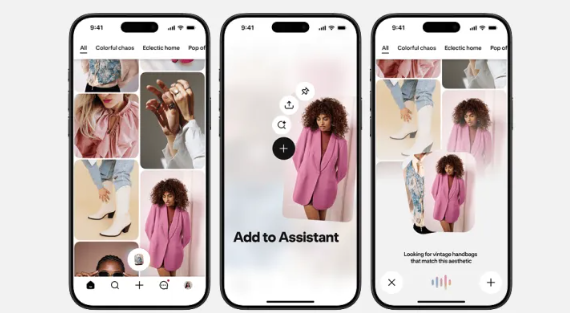

它的精细控制同样出彩。用户只需框选,就能锁定编辑范围,完成高难度操作,比如把某个物体移出框外。与此同时,UniWorld‑V2 的光影处理也很强,能把新元素自然融入场景,画面更协调。

在 GEdit‑Bench 与 ImgEdit 基准上,UniWorld‑V2 分别拿到 7.83 和 4.49 分,遥遥领先 OpenAI 的 GPT‑Image‑1、Gemini 2.0 等主流模型。其背后是 UniWorld‑R1 的强通用性加持,不仅让 UniWorld‑V2 受益,也能显著提升其他模型表现。

目前,UniWorld‑R1 的论文、代码与模型已在 GitHub 与 Hugging Face 开源,为后续研究打下基础。这次发布不仅推动多模态进展,也为图像编辑解锁更多玩法。

论文链接:

https://arxiv.org/abs/2510.16888

GitHub 项目:

https://github.com/PKU-YuanGroup/UniWorld

用户38505528 1个月前0

粘贴不了啊用户12648782 2个月前0

用法杂不对呢?yfarer 2个月前0

草稿id无法下载,是什么问题?