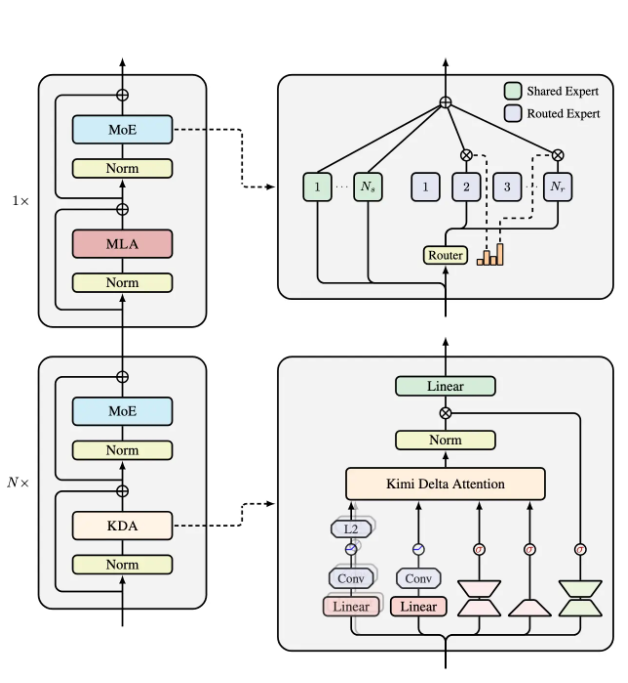

近日,月之暗面推出一套全新的混合线性注意力架构,名为 “Kimi Linear”。官方表示,它在处理短程与长程信息,以及强化学习(RL)等多种场景时,相比传统的全注意力方法表现更优。其核心技术 Kimi Delta Attention(KDA)是在 Gated DeltaNet 基础上的改进,引入更高效的门控机制,更好地控制有限状态 RNN 的记忆使用。

Kimi Linear 的整体由三路 Kimi Delta Attention 搭配一组全局 MLA 组成。通过细粒度门控压缩有限状态 RNN 的“记忆”,让信息处理更高效。官方给出的数据称,在 1M token 的场景下,Kimi Linear 的 KV cache 占用减少约 75%,解码吞吐量最高可提升至 6 倍,TPOT 相比传统 MLA 加速 6.3 倍。

这套新架构为多类 AI 应用提供了更强支撑:不论是信息密集的自然语言处理任务,还是动态环境中的强化学习,Kimi Linear 都有明显优势。随着 AI 技术持续发展,这类高效注意力机制有望为未来智能应用带来新的突破。

更多技术细节可查阅 Kimi Linear 技术报告:https://github.com/MoonshotAI/Kimi-Linear/blob/master/tech_report.pdf。

划重点:

🌟 Kimi Linear 是一种混合线性注意力新架构,重点提升信息处理效率。

🚀 在 1M token 场景下,KV cache 占用减少 75%,解码吞吐量提升至 6 倍。

🔍 Kimi Delta Attention 为核心技术,通过更细的门控优化 RNN 的记忆管理。

用户38505528 1个月前0

粘贴不了啊用户12648782 2个月前0

用法杂不对呢?yfarer 2个月前0

草稿id无法下载,是什么问题?