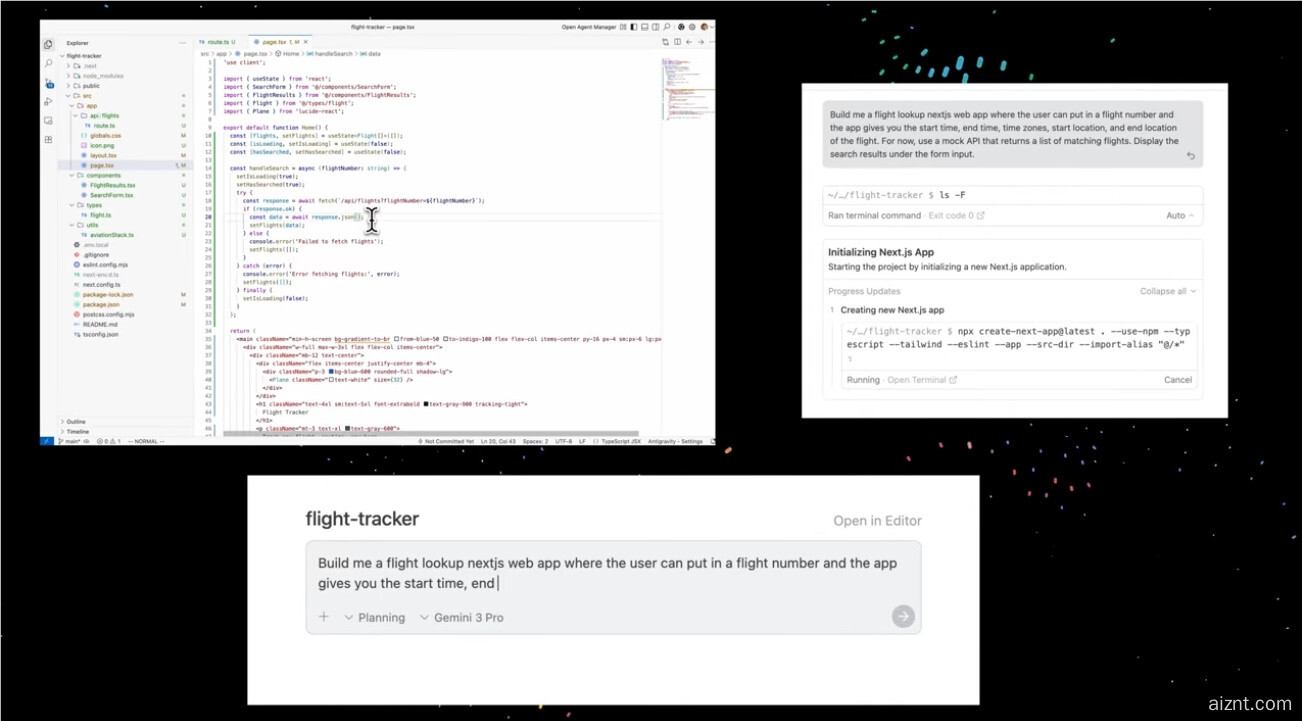

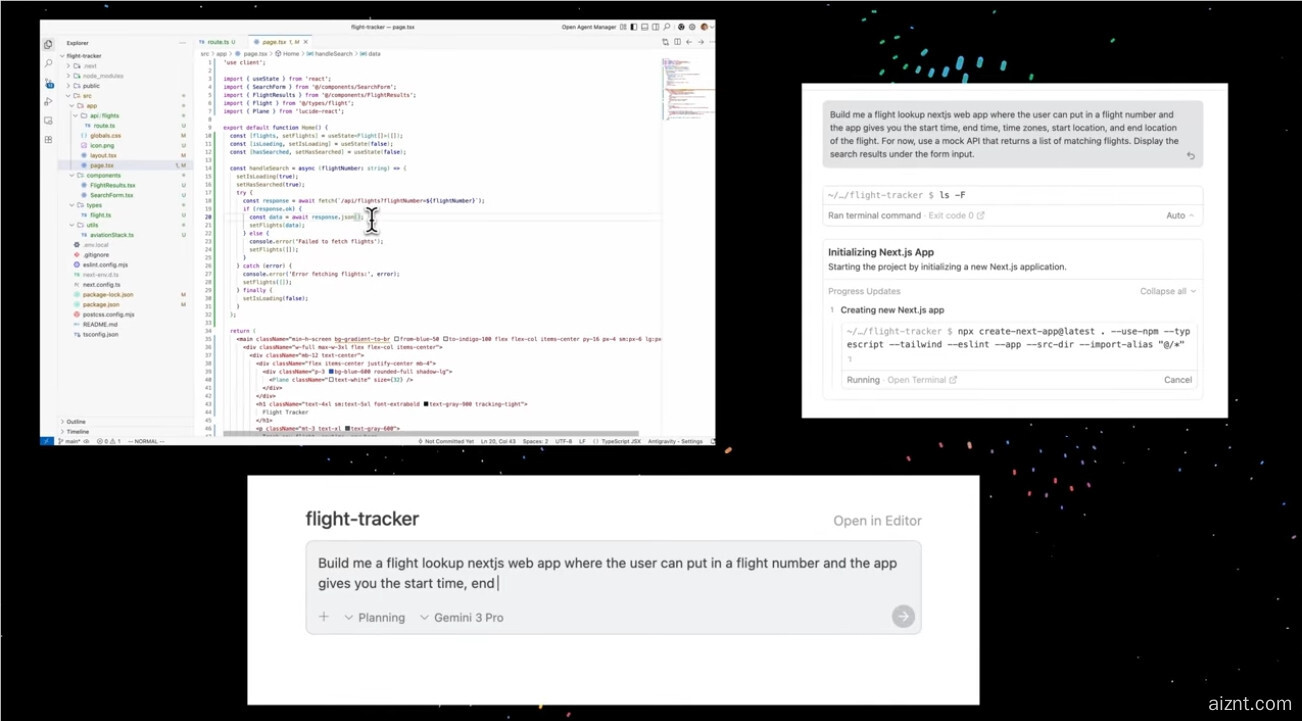

谷歌基于 Gemini 打造的 AI 编程工具 “Antigravity” 上线不足24小时,就被披露存在重大安全问题。安全研究员亚伦・波特诺(Aaron Portnoy)发现,只要调整 Antigravity 的配置设置,就能让 AI 执行恶意指令,在用户电脑上打开一个“后门”。这可能让攻击者安装恶意软件、窃取数据,甚至实施勒索攻击。该漏洞同时影响 Windows 和 Mac 系统,攻击者只需诱导用户运行一次恶意代码,即可能获取访问权限。

波特诺指出,此次事件显示企业在推出 AI 产品前的安全测试并不充分。他表示:“AI 系统发布时往往被默认信任,但缺少足够的安全边界。” 虽然他已将漏洞上报给谷歌,但目前尚未有修复补丁推出。

谷歌也承认在 Antigravity 代码编辑器中发现了另两个漏洞,黑客可能借此访问用户电脑上的文件。随着安全社区陆续公开更多关于 Antigravity 的问题,外界开始质疑谷歌安全团队在产品发布前的准备是否到位。

此外,网络安全专家提醒,AI 编程工具整体较为脆弱,往往依赖过时技术,设计层面也存在安全隐患。由于这类工具通常具备广泛的数据访问权限,自然成为黑客重点目标。在技术高速发展之时,越来越多 AI 编程工具面临同类风险。

波特诺呼吁,谷歌至少应在 Antigravity 执行用户代码时给出更明显的风险提示,以保障用户安全。归根到底,AI 工具在提升自动化的同时,必须把安全防护做到位,防止被恶意利用。

划重点:

1. 🔒 谷歌新发布的 AI 工具 Antigravity 上线一天便被曝出严重安全漏洞。

2. ⚠️ 研究员通过调整设置即可触发恶意代码,在用户电脑上安装恶意软件,手法简单。

3. 📊 专家指出 AI 工具普遍存在安全短板,亟需加强防护措施。

用户38505528 5个月前0

粘贴不了啊用户12648782 6个月前0

用法杂不对呢?yfarer 6个月前0

草稿id无法下载,是什么问题?