AMD联合IBM与AI初创公司Zyphra发布ZAYA1——全球首个从训练到部署全程基于AMD硬件完成的MoE基础模型,预训练覆盖14T tokens,综合表现与Qwen3系列相当;在数学与STEM推理上,即便未做指令微调,也已逼近Qwen3专业版。

训练规模

– 集群:IBM Cloud 128个节点×每节点8张AMD Instinct MI300X,共计1024卡;采用InfinityFabric+ROCm,峰值算力达750 PFLOPs

– 数据:14T tokens,使用课程学习,从通用网页逐步过渡到数学/代码/推理;后训练版本将另行发布

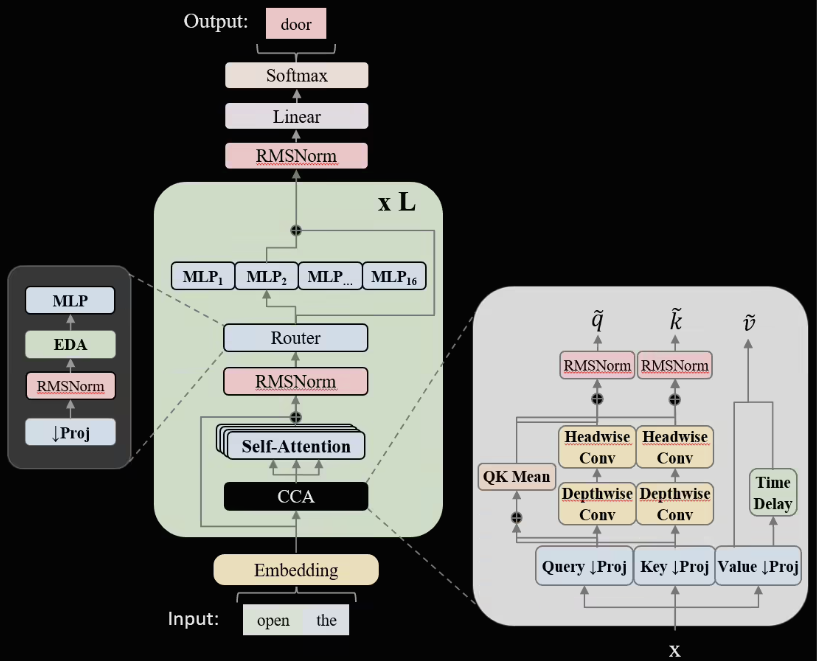

架构创新

1. CCA注意力:卷积结合压缩嵌入的注意力头,显存占用下降约32%,长上下文吞吐提升约18%

2. 线性路由MoE:细化专家粒度并加入负载均衡正则,Top-2路由精度提升2.3个百分点;在稀疏度达70%时仍能保持高利用率

基准成绩

ZAYA1-Base(非指令版)在MMLU-Redux、GSM-8K、MATH、ScienceQA等基准与Qwen3-Base持平;在CMATH与OCW-Math上有明显优势,验证了其在STEM方向的潜力。Zyphra透露,指令微调与RLHF版本将于2026年Q1推出,并开放API与模型权重下载。

AMD表示,此次合作证明MI300X+ROCm在大规模MoE训练中的可行性。后续将与更多云厂商复制“全AMD”集群方案,目标是在2026年训练规模超过100B参数的MoE模型时,实现与NVIDIA方案总体成本(TCO)持平。

© 版权声明

AI智能体所有文章,如无特殊说明或标注,均为本站作者原创发布。任何个人或组织,在未征得作者同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若此作者内容侵犯了原著者的合法权益,可联系客服处理。

THE END

用户38505528 5个月前0

粘贴不了啊用户12648782 6个月前0

用法杂不对呢?yfarer 6个月前0

草稿id无法下载,是什么问题?