MiniMax 正式推出 M2.5 模型,这是 M2 系列在 108 天内发布的第三个版本。该模型已在魔搭 ModelScope 同步开放权重,实现了能力、效率和成本上的同步升级,在编程、搜索、办公等多种场景中表现突出。同时还提供了从零代码使用到私有化部署的一整套接入方案,以及工具调用和推理参数调优的详细实战指南,正在加速推动低成本 Agent 时代的到来。

核心能力实现多维提升

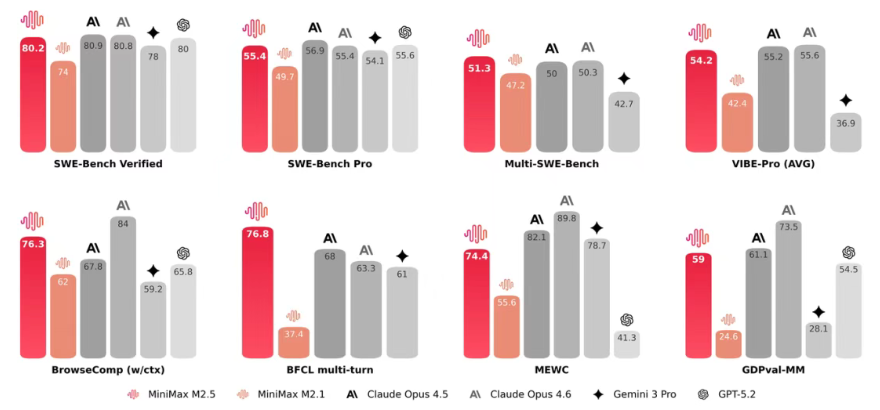

M2.5 在多项评测中表现优异,SWE-Bench Verified 达到 80.2%,超过 GPT-5.2,并接近 Claude Opus4.5;在 Multi-SWE-Bench 上以 51.3% 的成绩位居多语言编程能力前列;BrowseComp 得分 76.3%,在搜索和工具调用方面优势明显。在编程方面,模型展现出类似架构师的规划能力,能够覆盖完整的开发全流程,支持多平台全栈开发,对各类框架的适配能力优于 Claude Opus4.6;在搜索方面可以减少约 20% 的对话轮次,复杂搜索任务表现专业;在办公场景中融合金融、法律等领域知识,高级办公能力突出,内部对比测试中相较主流模型的胜率达到 59.0%。同时,M2.5 相比 M2.1 在推理速度上提升约 37%,耗时与 Claude Opus4.6 接近,但使用成本仅约其十分之一。

技术创新带来快速迭代

M2.5 的快速升级依托三项关键技术创新:其一是 Forge 原生 Agent 强化学习(RL)框架,将训练效率提升到约 40 倍;其二是 CISPO 算法,保证大规模训练过程中的稳定性,缓解长上下文场景下的“谁贡献了效果”的信用分配难题;其三是全新的 Reward 设计,在模型效果和响应速度之间取得平衡。凭借这些技术,MiniMax 内部约 30% 的日常任务和 80% 的新增代码由 M2.5 完成,M2 系列在 108 天内 SWE-Bench Verified 成绩从 69.4% 提升至 80.2%,迭代速度已跑在行业主流模型前面。

多种部署方式适配不同使用场景

M2.5 提供零代码、API 调用和本地部署三种接入形态,满足不同类型用户的需求。非技术用户可直接使用 MiniMax Agent 网页端,开箱即可使用,目前平台上已有超 10000 个用户创建的可复用“Expert”;开发者可以通过魔搭提供的免费 API 或官方 API 接入,官方同时推出 Lightning 版和标准版两种 API 规格,价格大约为同类模型的 1/10 至 1/20;本地部署方面,支持 SGLang、vLLM、Transformers、MLX 四种实现路径,分别覆盖高并发生产环境、中小规模生产、快速验证以及 Mac 本地开发等不同场景,并给出了每种方案对应的硬件配置建议和操作步骤。

工具调用与推理参数有专门方案

M2.5 原生支持结构化工具调用,可以同时并行调用多个工具。通过 vLLM/SGLang 部署时,可直接沿用 OpenAI SDK 的调用格式;使用其他框架时,则需要手动解析模型输出的 XML 格式,并根据官方示例将工具执行结果回传给模型,整个流程和实践方式都有完整说明。在推理参数上,官方建议使用 temperature=1.0、top_p=0.95、top_k=40 的默认配置,并鼓励针对不同业务场景做灵活微调;在编程场景的提示词上,建议充分发挥模型的“架构师思维”,同时模型对 10 多种编程语言和多种脚手架工具都有良好的适配表现。

用户38505528 5个月前0

粘贴不了啊用户12648782 6个月前0

用法杂不对呢?yfarer 6个月前0

草稿id无法下载,是什么问题?