在人工智能圈,参数规模曾被视为性能的绝对王者,但一个最新的开源项目正在改写这一认知。MiroThinker1.5是一款仅有30亿参数的研究型智能体,凭借高效的“交互式扩展”机制,拿出了接近万亿参数模型的表现,同时把推理成本降到原来的1/20。这不仅意味着AI正从“拼算力”转向“拼智能密度”,也为开源生态注入了强劲动力。下面是对此事件的深入解读。

性能突破:小模型也能有大智慧

MiroThinker1.5以30亿参数的轻量设计,对标并超越了多款万亿级别的基准模型,如Kimi-K2-Thinking。在中文浏览评测(BrowseComp)中表现抢眼,击败了不少更大的模型。其核心在于“交互式扩展”(Interactive Scaling):重视“代理密度”(Agentic Density),而不是一味堆参数。模型会实时找证据、反复校对、验证假设,形成强大的代理式搜索能力。单次查询推理费用约0.07美元,约为传统1T模型的1/20,显著降低使用门槛,推动从“静态推理”迈向“原生智能”。

核心技术亮点:多轮思考与自我纠错

该模型的关键是带内存管理的多轮推理。它会保留最近5次对话的核心上下文,并清理不相关的历史信息,兼顾信息完整性和资源效率。这种设计让模型具备“自主探究”(self-directed inquiry)能力,单个任务最多可进行400次工具交互,形成递归、分层的推理链。MiroThinker1.5支持自动信息搜索、多步思考与自我修正、长时记忆与上下文理解、工具调用与执行,以及研究级的信息整合与评估等能力。得益于此,它在复杂任务中更稳健,并能避免传统模型常见的“后见之明泄露”(hindsight leakage)。

真实场景测试:从历史回顾到深度报告

在实测中,MiroThinker1.5展现出不俗实力。比如给出任务“回顾人类历史上的每一次知识革命(如文字、印刷、电力、互联网),分析AI革命的独特性与潜在风险,并讨论其对文明演化的影响”,模型会进行多轮推理与检索,多次交叉验证后再继续搜索,覆盖中外多个来源与文献,最终产出完整报告。这说明它在理解问题、规划步骤、调用工具与解决复杂任务方面非常到位。用户反馈称,模型在处理敏感议题或抓取实时信息时表现尤为突出,明显优于传统搜索引擎的“现学现卖”模式。

行业观察:开源正在重构AI版图

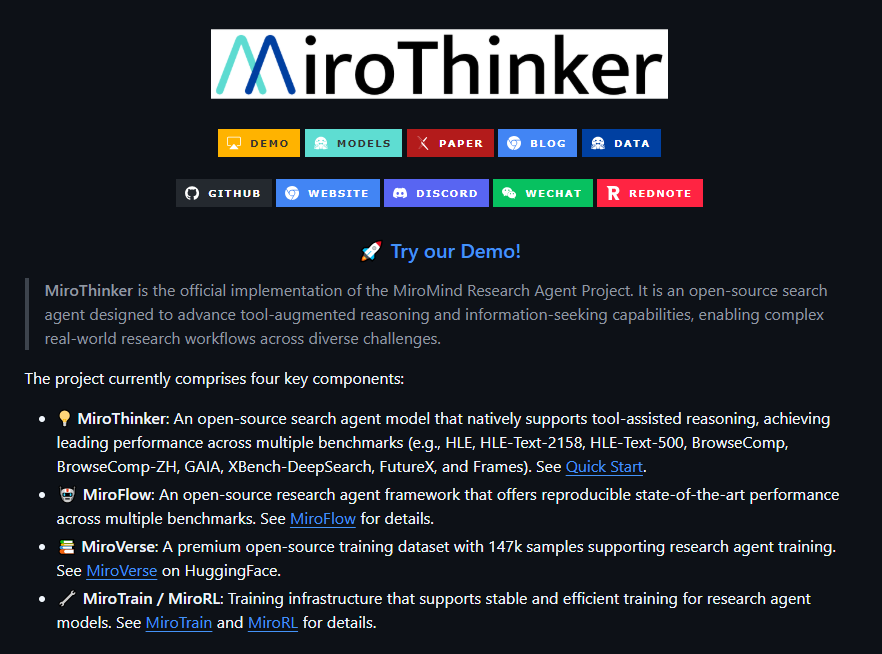

MiroThinker1.5的到来被不少人称为AI领域的“DeepSeek时刻”。它挑战了以往的缩放定律(Scaling Law),从参数堆叠转向方法驱动的调查式推理。以开源方式发布(在GitHub与Hugging Face可获取),不仅降低了训练与推理成本,也为中小团队与研究者提供了高效工具。业内人士指出,在许多机构为提升1%准确率投入巨资的当下,这种“交互式增长”很可能成为通往代理时代(Agentic Era)的关键路径。未来的AI竞争将更看重“智能密度”,而非简单的参数规模,这或将打破旧有格局,推动更高效的逻辑构建。

综合来看,MiroThinker1.5预示着AI正从“巨兽时代”迈向“智慧时代”。它不仅为开源社区带来新希望,也提醒从业者:真正的突破在于方法,而不只是规模。后续进展值得持续关注。

项目地址:https://github.com/MiroMindAI/MiroThinker

用户38505528 5个月前0

粘贴不了啊用户12648782 6个月前0

用法杂不对呢?yfarer 6个月前0

草稿id无法下载,是什么问题?