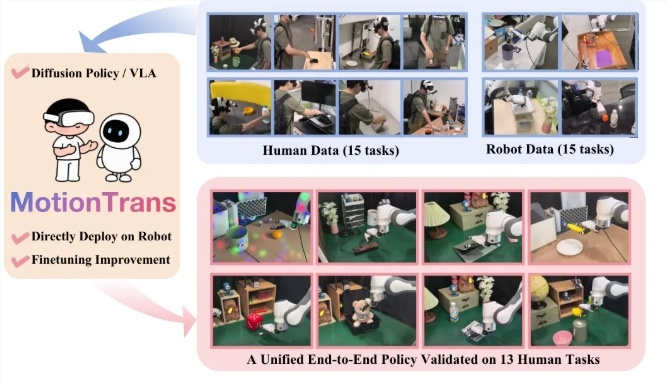

近日,清华大学、北京大学、上海交通大学、武汉大学等校联合推出一套名为 MotionTrans 的人机协同训练框架。它的亮点是:不需要人工示范,机器人只看人的动作就能学会并完成全新的技巧。这被视为机器人学习上的一次重要进展。

过去训练机器人往往要大量真实演示,采集过程既耗时又昂贵。比如想教机器人拧瓶盖,就得反复示范并记录细节。现在,MotionTrans 借助虚拟现实(VR)设备,能够精细捕捉人类手部动作,为机器人的学习提供高质量依据。

在具体实施中,研究团队使用便携式 VR 装置,任何人都能随时参与录制。系统不仅采集佩戴者的手部关键点,还会同步获取第一人称视角的视频,保证数据清晰且信息充足。数据收集完成后,团队构建了一个包含 3,213 条演示的数据集,覆盖多类人机任务。

关键技术在于把人的动作转换成机器人能理解并执行的形式。研究者通过优化方法,将人手的细微动作精准映射到机器人的关节角度,使机器人能在真实环境中复现这些动作。同时,为了更适配机器人的工作特性,还对动作速度与舒适工作区进行调整,确保运行安全稳定。

这套创新框架的推出,让机器人能够更自然地模仿人类动作,更高效地掌握新技能,为未来的人机协作打下坚实基础。

github:https://github.com/michaelyuancb/motiontrans

要点速览:

🦾 MotionTrans 框架发布,机器人可在零示范条件下学会新技能。

👾 用 VR 设备采集人手部动作,沉淀高质量、丰富的数据集。

🔧 将人类动作翻译成机器人可执行的指令,提升技能迁移效率。

© 版权声明

AI智能体所有文章,如无特殊说明或标注,均为本站作者原创发布。任何个人或组织,在未征得作者同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若此作者内容侵犯了原著者的合法权益,可联系客服处理。

THE END

用户38505528 1个月前0

粘贴不了啊用户12648782 2个月前0

用法杂不对呢?yfarer 2个月前0

草稿id无法下载,是什么问题?