AI视觉生成迎来一次范式级升级。MiniMax与华中科技大学近日联合开源其关键技术——VTP(Visual Tokenizer Pretraining,视觉分词器预训练)。在不改动标准DiT(Diffusion Transformer)架构的前提下,只优化视觉分词器,即可带来端到端图像生成性能65.8%的提升。这项成果打破了“只能靠堆大模型提性能”的惯性认知,首次把视觉分词器推向了前所未有的高度。

主模型不动,只改“翻译官”——性能也能起飞

传统生成模型(如DALL·E3、Stable Diffusion3)往往依靠DiT等主干网络来提升效果,而VTP走的是另一条路:把视觉分词器——这个负责把图像压缩成离散token序列的“视觉翻译官”——作为核心优化对象。

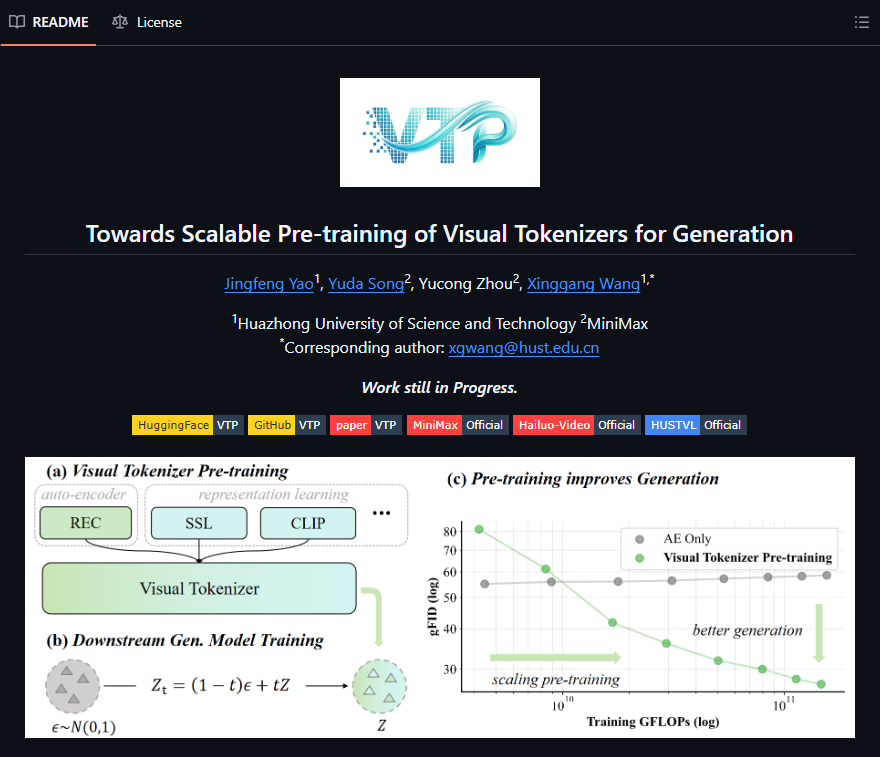

关键在于,VTP无需动DiT的训练流程或结构,只在分词器的预训练阶段做针对性优化,让其输出的latent表征更好学、更通用,从而让下游DiT“事半功倍”。实验显示,在相同DiT配置下,接入VTP的系统在生成质量(FID、CLIP Score等指标)上显著超过基线。

首次构建“分词器可扩展性”理论框架

VTP的突破不仅是工程层面的优化,更带来全新的理论视角:

– 首次清晰地将latent表征的易学性(learnability)与通用视觉表征能力建立联系;

– 首次证明分词器本身具备可扩展性(tokenizer scaling)——随着分词器容量、训练数据与预训练策略增强,生成性能呈现明确的scaling曲线;

– 为行业打开“主模型之外的性能增长路径”:未来不必一味增大DiT参数,通过优化分词器即可获得更高性价比的性能提升。

开源即赋能,推动视觉生成走向大众

目前,VTP的代码、预训练分词器及训练配方已全面开源,且兼容主流DiT实现。这意味着,任何使用DiT架构的研究者或企业,都能“即插即用”VTP,用更低成本拿到近70%的生成质量提升,尤其适合算力有限的中小团队。

业内普遍认为,VTP的发布标志着AI生成技术进入“系统级优化”的新阶段。当行业从“唯大模型论”转向“全链路协同提效”,MiniMax与华中科大的此次合作,不仅是一次技术突破,也是对“高效AI”理念的有力实践——真正的创新,有时不在于把引擎做得更大,而在于让每个零件更聪明地协同。

代码:https://github.com/MiniMax-AI/VTP

论文:https://arxiv.org/abs/2512.13687v1

用户38505528 5个月前0

粘贴不了啊用户12648782 6个月前0

用法杂不对呢?yfarer 6个月前0

草稿id无法下载,是什么问题?