通义千问团队今日推出全新的图像生成模型 Qwen-Image-Layered。依托自研的创新架构,它突破了传统 AI 修图的限制,通过“图层拆解”让原本静态的图片具备可编辑性,实现真正的“指哪儿改哪儿”的精准修改体验。

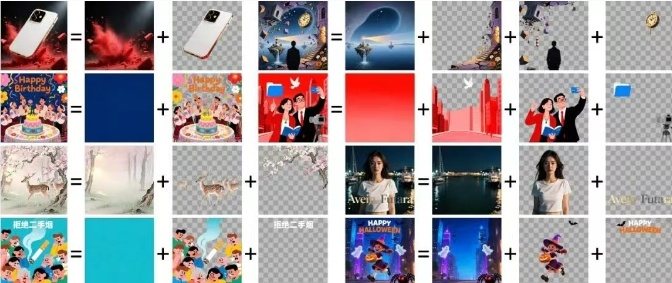

目前 AI 图片编辑普遍存在两大难点:做全局调整时容易破坏未改动区域的一致性;用掩码做局部修改时,遇到遮挡和边缘不清会很难处理。Qwen-Image-Layered 提出“图像解耦”的新思路,把图片自动拆分为语义独立的 RGBA 图层,像把蛋糕一层层分开。每一层都拥有自己的颜色信息(RGB)和透明度(Alpha),可以单独操作而不影响其他层。

该模型的核心亮点十分突出:全新的 RGBA-VAE 让 RGB 整图与 RGBA 图层共享同一潜在空间,缓解图层分布不均、边界模糊等问题;VLD-MMDiT 架构可灵活处理 3 层到 10 层以上的内容,图层之间通过注意力机制协同,不需要低效的递归拆解;训练路径经历“生成单张图 → 生成多图层 → 分解任意 RGB 图片”的多阶段进化,实现从生成能力到理解与拆解能力的转化。

在实际应用中,模型可以完成重新上色、替换物体、修改文字、删除元素、缩放与移动等操作。更值得一提的是,它支持可变数量的图层拆分:同一张图片既可按需拆成 3 层,也能拆成 8 层;并且任意图层都能继续递归分解,实现层级不限的细粒度编辑。

目前,Qwen-Image-Layered 的技术报告、代码仓库及在线 Demo 已在 arXiv、GitHub、ModelScope 等平台上线。通义千问团队表示,希望借助该模型将图片重构为可组合的图层,为用户提供直观、精准且稳定可靠的编辑能力。

技术报告:

https://arxiv.org/abs/2512.15603

Github:

https://github.com/QwenLM/Qwen-Image-Layered

ModelScope:

https://www.modelscope.cn/models/Qwen/Qwen-Image-Layered

Hugging Face:

https://huggingface.co/Qwen/Qwen-Image-Layered

Demo:

https://www.modelscope.cn/studios/Qwen/Qwen-Image-Layered

用户38505528 5个月前0

粘贴不了啊用户12648782 6个月前0

用法杂不对呢?yfarer 6个月前0

草稿id无法下载,是什么问题?