在大语言模型技术的新趋势下,蚂蚁技术研究院近日正式推出 LLaDA2.0 系列,这是业界首个参数规模达 100B 的离散扩散大语言模型(dLLM)。该模型打破了“扩散模型难以规模化”的固有认知,在生成质量和推理速度上都有明显提升,为大模型的发展带来新的方向。

LLaDA2.0 系列包含两种版本:16B(mini)与 100B(flash)。此次发布的 100B 版本,是目前最大的扩散语言模型,尤其擅长复杂代码生成与指令执行。蚂蚁方面表示,LLaDA2.0 采用全新的 Warmup‑Stable‑Decay(WSD)预训练策略,可无缝承接自回归(AR)模型的知识,避免从零开始训练的高成本。

在技术细节上,LLaDA2.0 展现出并行解码优势,推理速度可达 535 tokens/s,比同级 AR 模型快 2.1 倍。该速度提升来自推理阶段的 KV Cache 复用与块级并行解码。此外,在后训练阶段通过互补掩码和置信度感知并行训练(CAP),进一步提高了数据效率与推理速度。

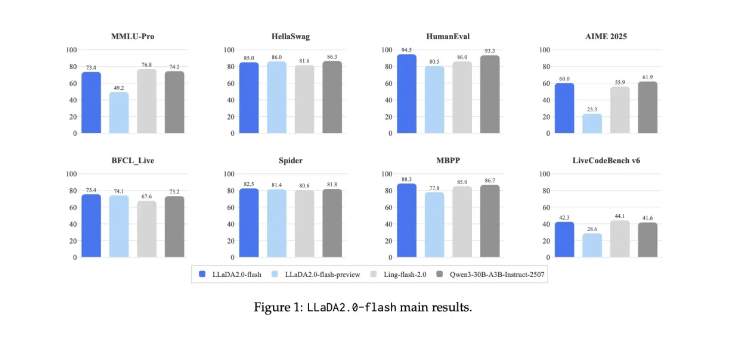

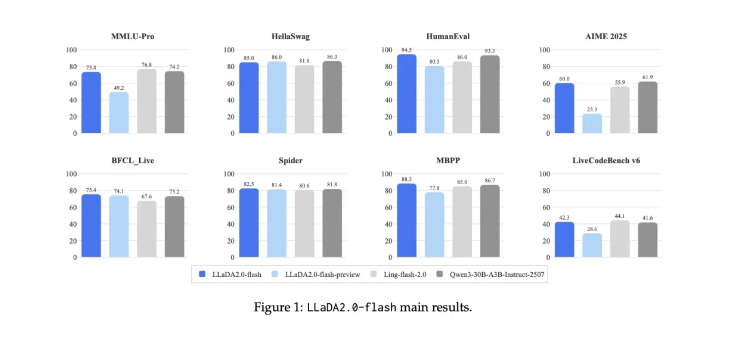

LLaDA2.0 在多项评测中表现亮眼,尤其在结构化生成任务(如代码生成)中,展现出更强的全局规划能力;在复杂的智能体调用与长文本任务中同样表现稳定,适应多种应用场景。

此次发布既是离散扩散技术的重要里程碑,也证明了其在超大规模应用中的可行性与优势。未来,团队将继续挖掘扩散模型的潜力,计划扩大参数规模,深入结合强化学习与思考范式,推动生成式人工智能的进展。

地址:https://huggingface.co/collections/inclusionAI/llada-20

© 版权声明

AI智能体所有文章,如无特殊说明或标注,均为本站作者原创发布。任何个人或组织,在未征得作者同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若此作者内容侵犯了原著者的合法权益,可联系客服处理。

THE END

用户38505528 5个月前0

粘贴不了啊用户12648782 6个月前0

用法杂不对呢?yfarer 6个月前0

草稿id无法下载,是什么问题?