苹果公司正式推出全新视频生成模型 STARFlow-V。与当前主流的 Sora、Veo、Runway 等在底层方案上截然不同,STARFlow-V 不再采用扩散模型(Diffusion Model),而是引入“归一化流”(Normalizing Flow),用来解决长视频生成中的稳定性与误差累积问题。

扩散模型依靠多步去噪迭代合成视频;而 STARFlow-V 的“归一化流”直接学习随机噪声与复杂视频数据之间的可逆变换。这一本质差异带来多项优势:

-

训练效率:一次性完成训练,无需反复小步迭代,效率更高。

-

生成速度:训练完成后可直接生成视频,不用迭代推理,速度大幅提升。

-

错误减少:降低逐步生成中常见的累积失真与错误。

苹果表示,STARFlow-V 是首个在画质与速度上可与扩散模型媲美的同类技术。通过并行处理并复用上一帧信息,其生成 5 秒视频的速度相较初版提升约 15 倍。

双架构应对长视频难题

生成长序列一直是视频 AI 的难点,逐帧生成容易产生误差累积。STARFlow-V 采用双架构来缓解这一问题:

-

一套组件负责跨帧时间一致性(保证运动连贯)。

-

另一套组件专注单帧内细节(提升画面质量)。

借助该设计,STARFlow-V 在长达 30 秒的演示片段中保持稳定;而如 NOVA、Self-Forcing 等方法在数秒后就开始出现模糊或偏色。

多功能性与性能表现

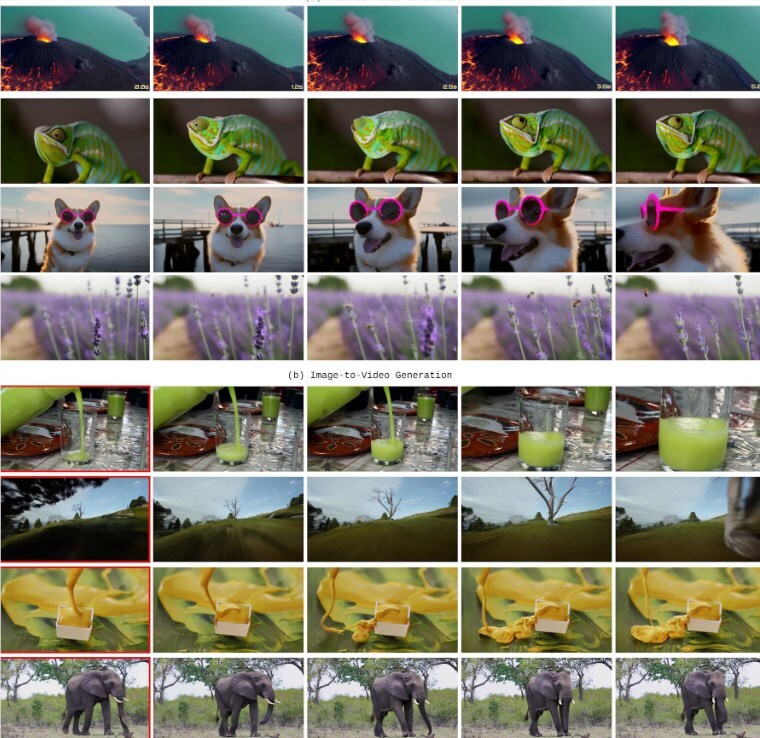

该模型无需改动即可胜任多种任务,包括:

-

文本转视频(Text-to-Video)。

-

图像转视频(Image-to-Video),把输入图像作为起始帧。

-

视频编辑,支持添加或移除对象。

在 VBench 基准中,STARFlow-V 取得79.7 分。虽然不及 Veo3(85.06)和 HunyuanVideo(83.24)等顶尖扩散模型,但明显优于其他自回归模型,尤其在空间关系与人体表征方面表现更好。

尽管技术亮点突出,STARFlow-V 仍有局限:分辨率较低(640×480,16 帧/秒),且目前无法在常规显卡上实时运行。

更关键的是,其在物理一致性上还有不足,例如“章鱼穿过玻璃”“石头突然出现”等不合理现象。

苹果表示,后续将重点加快计算、缩小模型规模,并使用更注重物理规律的数据进行训练。相关代码已在 GitHub 开源,模型权重随后将于 Hugging Face 发布。

用户38505528 5个月前0

粘贴不了啊用户12648782 6个月前0

用法杂不对呢?yfarer 6个月前0

草稿id无法下载,是什么问题?