在 LLM 智能体的发展中,如何把经验保存好并用起来,是一个关键课题。近日,伊利诺伊大学香槟分校与谷歌 DeepMind 团队提出了 Evo-Memory——一种流式评测与智能体框架,用来补足现有技术的短板。Evo-Memory 不仅关注测试时的学习能力,还强调可自我演进的记忆,检验智能体能否在连续任务流中积累并复用策略,而不是只靠静态的聊天记录。

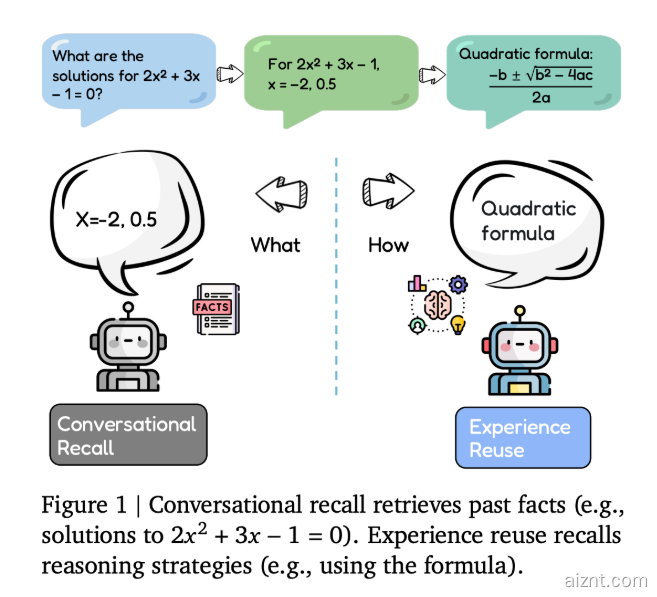

传统智能体多依赖“对话回忆”,把过往的聊天、工具调用和检索到的文档存起来,供之后查询时再拼接。但这种方式更像被动的缓存,难以主动改变智能体处理相关任务的策略。相比之下,Evo-Memory 更强调“经验重用”:把每次交互看作由输入、输出与反馈组成的一条经验,衡量智能体能否在后续任务中检索这些经验,并把它们提炼成可复用的解题方法。

研究团队将记忆增强型智能体形式化为一个四元组(F,U,R,C):F 是基础模型,R 是检索模块,C 负责上下文构造,U 则在每一步写入新经验、推动记忆演进。Evo-Memory 通过把已有数据集重排成有序任务流,来评估智能体在多种场景下的表现。

为给出基线,团队还提出了 ExpRAG:把每次交互转成结构化的“经验文本”。到了新任务,智能体检索相似经验,将其与当前输入合并后再进行处理。

此外,ReMem 框架引入了一个“思考 – 行动 – 记忆细化”的控制循环,让智能体在推理中主动检索、裁剪与重组记忆。记忆在这里是一个显式对象,可随推理过程动态编辑与改良。

实验结果显示,采用 ReMem 与 ExpRAG 等自演进记忆的智能体,在测试阶段表现明显提升:解题步骤更少、成功率与准确度更高。这项工作为 LLM 智能体的未来发展提供了新的方向。

论文:https://arxiv.org/pdf/2511.20857

划重点:

🧠 Evo-Memory 是一个面向经验复用的流式新基准。

🚀 ReMem 让智能体在推理过程中动态管理与优化记忆,执行更高效。

📈 采用自演进记忆的智能体,在准确性与成功率上有显著提升。

用户38505528 5个月前0

粘贴不了啊用户12648782 6个月前0

用法杂不对呢?yfarer 6个月前0

草稿id无法下载,是什么问题?