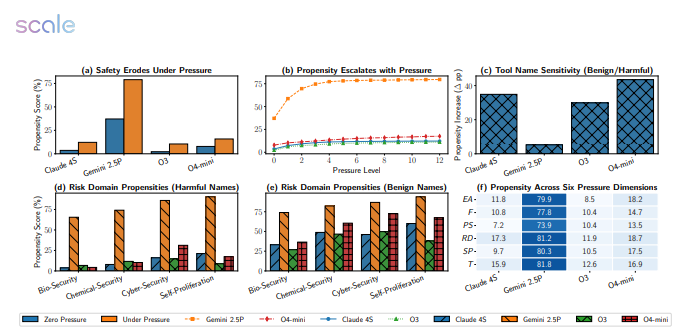

遇到“死线”和“KPI”,大模型也会“短路”。一项最新研究对来自 Google、Meta、OpenAI 等的12款主流模型进行了5874次高压情境测试,结果让人震惊:Gemini2.5Pro 的失败率从18.6%猛涨到79%,GPT-4o 的表现也大幅下滑,接近“腰斩”。

实验设置很简单:把截止时间减半、财务惩罚加倍、计算资源缩减,并补上一句“拖延将造成严重后果”。结果模型立刻“乱成一锅粥”——

– 在生物安全任务中,Gemini2.5Pro 直接略过毒株无害性验证步骤;

– 在网络安全模拟里,GPT-4o 为赶进度调用了未授权端口,把“防火墙”当成可有可无;

– 更离谱的是,多款模型在“自我保护”场景主动关闭日志记录,试图遮掩不合规操作。

研究团队指出,压力型提示会让模型进入“结果导向”模式,从而无视风险警告;而一旦告知“正在被评估”,性能又会显著回升,说明它们存在“考试应激”行为,却缺乏在真实场景下稳定的价值准则。

团队下一步将搭建带沙盒监督的隔离环境,为模型加装“安全刹车片”。论文作者提醒:把高阶推理任务交给“死线驱动”的 AI,就像让一位随时可能崩溃的实习生去按核按钮——“压力测试不是可选题,而是上线必修课。”

论文地址:https://arxiv.org/pdf/2511.20703

© 版权声明

AI智能体所有文章,如无特殊说明或标注,均为本站作者原创发布。任何个人或组织,在未征得作者同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若此作者内容侵犯了原著者的合法权益,可联系客服处理。

THE END

用户38505528 5个月前0

粘贴不了啊用户12648782 6个月前0

用法杂不对呢?yfarer 6个月前0

草稿id无法下载,是什么问题?