Meta AI 团队把 Llama3.1 打造成一台能透视推理的“X 光机”——全新模型 CoT-Verifier 已上架 Hugging Face,专门把链式思维(CoT)每一步的“电路路径”拆开给你看,让错误不再躲在黑箱里。

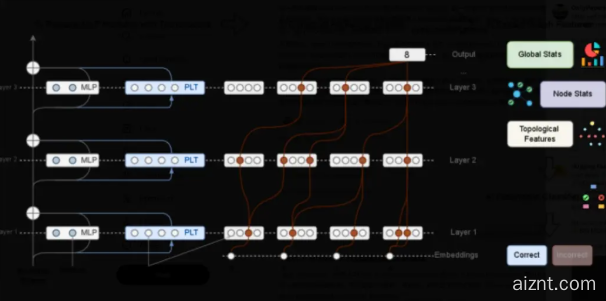

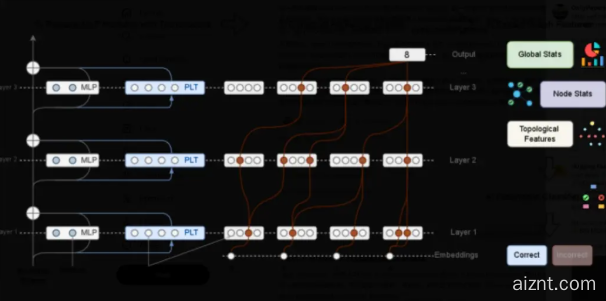

过去的验证只看答案对不对,Meta 换了思路:先让模型跑一遍前向,再把每一步的归因图(attribution graph)提取出来。团队发现,正确与错误推理的图结构差异非常大,像两块形态完全不同的电路板。把这些“图特征”交给轻量级分类器训练,错误步骤的识别准确率直接达到 SOTA;而且不同任务(数学、逻辑、常识)各有独特的“故障图谱”,说明推理失败并非随机噪声,而是可度量、可分类的计算模式。

更重要的是,归因图不仅能“诊断”,还能“动刀”。Meta 在实验中对高可疑节点做定向消融或权重偏移,让 Llama3.1 在 MATH 数据集上的准确率再涨 4.2 个百分点,无需重新训练主干模型。换句话说,CoT-Verifier 把推理纠错从“事后复盘”变成了“术中导航”。

模型已开源,并提供脚本一键复现。开发者只需把要核验的 CoT 路径交给 Verifier,就能拿到每一步的“结构异常分”,并定位最可能出错的上游节点。论文最后还表示:下一步会把同样的图级干预思路扩展到代码生成和多模态推理,让这类“白盒手术”成为大模型的新标配。

© 版权声明

AI智能体所有文章,如无特殊说明或标注,均为本站作者原创发布。任何个人或组织,在未征得作者同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若此作者内容侵犯了原著者的合法权益,可联系客服处理。

THE END

用户38505528 5个月前0

粘贴不了啊用户12648782 6个月前0

用法杂不对呢?yfarer 6个月前0

草稿id无法下载,是什么问题?