今日,小米面向公众发布具身大模型 MiMo-Embodied,并同步宣布该模型将全面开源。这一步意味着小米在通用具身智能研究上取得了重要进展。

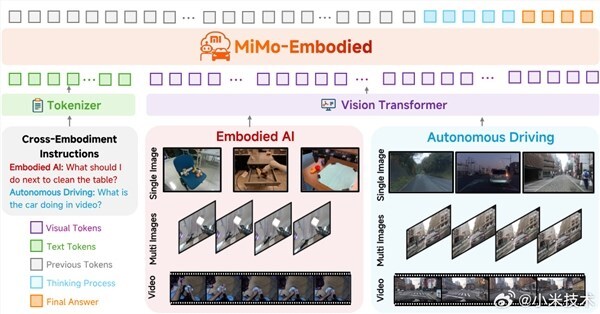

随着具身智能在家居场景逐步落地、自动驾驶加速规模化应用,业界普遍关注如何让机器人与车辆在认知与能力上打通,以及室内操作智能与室外驾驶智能能否相互促进。此次发布的 MiMo-Embodied 正是为解决这些问题而打造,它把自动驾驶与具身智能两大领域贯通起来,通过统一的任务建模,实现从“垂直领域专用”向“跨域能力协同”的关键跨越。

MiMo-Embodied 的技术有三大亮点。首先,它具备跨域能力覆盖,可同时支持具身智能的三项核心任务——可供性推理、任务规划、空间理解,以及自动驾驶的三项关键任务——环境感知、状态预测、驾驶规划,为全场景智能提供坚实支撑。其次,模型验证了室内交互与道路决策之间的知识迁移效果,展现出跨场景协同的新思路。最后,MiMo-Embodied 采用“具身/自驾能力学习 + CoT 推理增强 + RL 精细强化”的多阶段训练策略,显著提升模型在真实环境中的落地稳定性与可靠性。

在性能方面,MiMo-Embodied 在覆盖感知、决策、规划的 29 项核心基准上树立了开源基座模型的新标杆,整体优于现有的开源、闭源及专用模型。在具身智能方向,模型在 17 个基准上拿到 SOTA 成绩,进一步提升了任务规划、可供性预测与空间理解的上限;在自动驾驶方向,它在 12 个基准上表现突出,完成了从环境感知到状态预测、再到驾驶规划的全链路突破。此外,在通用视觉语言能力上,MiMo-Embodied 也展现了强泛化能力,在夯实通用感知与理解的同时,在多项关键基准上取得明显提升。

开源地址:

-

https://huggingface.co/XiaomiMiMo/MiMo-Embodied-7B

用户38505528 5个月前0

粘贴不了啊用户12648782 6个月前0

用法杂不对呢?yfarer 6个月前0

草稿id无法下载,是什么问题?