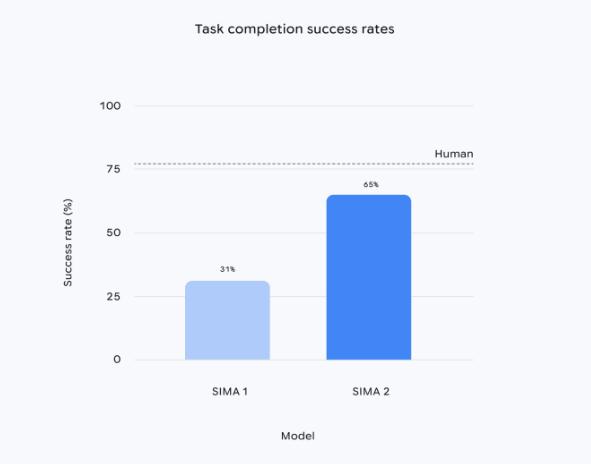

Google DeepMind上线多模态智能体SIMA2,依托Gemini2.5 Flash-lite模型,任务成功率较SIMA1约提升一倍;它能在未见过的场景中完成复杂指令,并具备自我优化能力。该版本以研究预览形式开放,旨在验证通向通用机器人与AGI所需的高层世界理解与推理能力。

SIMA2仍以数百小时的游戏视频进行预训练,但首次引入自生成数据闭环:进入新场景后,系统调用独立Gemini模型批量生成任务;由内部奖励模型打分,筛选高质量轨迹用于持续微调,无需额外人工标注即可不断提升表现。研究团队表示,这使智能体在《No Man’s Sky》等测试环境中,能通过读取环境文本、识别颜色和符号,自主执行“前往红色房屋”“砍伐树木”等指令,甚至能够理解由emoji组合的命令。

在演示中,DeepMind将生成式世界模型Genie与SIMA2结合,实时生成逼真的户外场景;智能体能准确识别长椅、树木、蝴蝶等对象并进行交互。高级研究科学家Jane Wang表示,这种“看懂场景→推断目标→规划动作”的闭环,正是把虚拟环境能力迁移到真实机器人所需的高层行为模块。

需要说明的是,SIMA2当前专注于高层决策,并不涉及机械关节、轮子等底层控制。DeepMind同期训练的机器人基础模型采用不同技术路线,两者如何融合尚未确定。团队未透露正式版发布时间,仅称希望通过研究预览吸引外部合作,共同探索虚拟智能体向实体机器人迁移的可行路径。

© 版权声明

AI智能体所有文章,如无特殊说明或标注,均为本站作者原创发布。任何个人或组织,在未征得作者同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若此作者内容侵犯了原著者的合法权益,可联系客服处理。

THE END

用户38505528 5个月前0

粘贴不了啊用户12648782 6个月前0

用法杂不对呢?yfarer 6个月前0

草稿id无法下载,是什么问题?