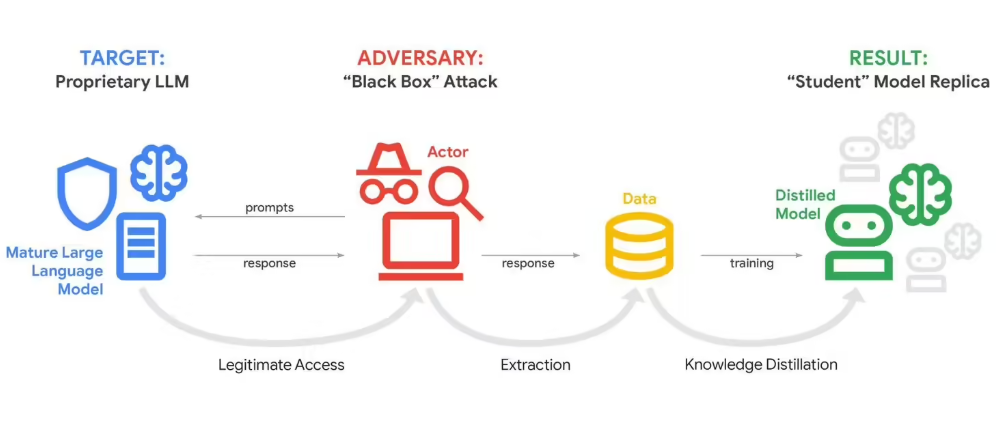

当地时间 2 月 12 日,谷歌公开表示,其旗下 AI 对话产品 Gemini 正遭遇一轮大规模“蒸馏攻击”。攻击者通过海量、重复的提问方式,一点点诱导模型暴露内部工作机制,其中单次攻击的提示次数竟超过 10 万次。这一事件让业界对大模型安全问题更加警觉。据介绍,这类攻击会不断试探 Gemini 的回答模式和思考路径,试图摸清其核心内部逻辑,从而在后续用来复制模型能力,或进一步提升自身的 AI 系统。

谷歌透露,此次攻击主要来自具有商业目的的行为方,背后多是想要在竞争中占据优势的 AI 公司或研究团队,攻击源分布在全球多个地区。不过,谷歌没有公布更具体的嫌疑对象信息。谷歌威胁情报小组首席分析师约翰・霍特奎斯特指出,这次攻击的规模已经释放出危险信号,这类蒸馏攻击很可能正向中小企业的定制化 AI 工具扩散。

他把谷歌当前面临的情况比作“煤矿里的金丝雀”,意思是大型平台暴露出的安全问题,其实是在提前提醒整个 AI 行业:类似风险很快会普遍出现。谷歌强调,蒸馏攻击从根本上说是一种知识产权盗用行为。各大科技公司为打造大语言模型投入了数十亿美元,而模型的内部机制正是最核心的专有资产。

尽管业内已经上线了一些识别、监控和阻断此类攻击的安全方案,但由于主流大模型服务普遍对公众开放,从模式上就很难完全避免这类威胁。本次针对 Gemini 的攻击重点瞄准其“推理”算法,也就是处理信息时作出判断和决策的关键机制。

霍特奎斯特提醒,随着越来越多企业基于内部敏感数据训练自家的定制大模型,蒸馏攻击带来的潜在影响会不断放大。严重时,企业积累多年的业务经验、核心方法论和关键知识,很可能被攻击者通过这种方式一步步抽取出来。

用户38505528 5个月前0

粘贴不了啊用户12648782 6个月前0

用法杂不对呢?yfarer 6个月前0

草稿id无法下载,是什么问题?