具身智能(Embodied AI)领域迎来重要进展。小米正式对外开源其首代机器人大模型

核心架构:大脑与小脑的协同

为兼顾通用理解与高频控制,Xiaomi-Robotics-0 采用创新的 MoT(Mixture-of-Transformers)混合架构:

-

视觉语言大脑(VLM): 作为基座,负责理解人类模糊指令,并从高清画面中抓取精细的空间关系。

-

动作执行小脑(Action Expert): 内部引入多层 Diffusion Transformer(DiT),通过流匹配(flow matching)方法生成精准的“动作块(Action Chunk)”,保证物理执行的灵活与稳定。

训练秘籍:两阶段进化论

小米团队以严谨的训练流程,兼顾常识理解与实体操作能力:

-

跨模态预训练: 通过 Action Proposal 机制,让 VLM 在保持逻辑推理能力的同时,实现特征空间与动作空间的对齐。随后冻结 VLM,针对 DiT 专项训练,以生成平滑且连贯的动作序列。

-

后训练(Post-training): 面向真机运行中常见的“动作断层”问题,采用异步推理模式。结合 Clean Action Prefix(确保轨迹连续性)与 Λ-shape Attention Mask(强化对当前视觉反馈的关注),使机器人在环境突发变化时具备更强的快速响应能力。

实战表现:刷新多项 SOTA

在多重测试中,Xiaomi-Robotics-0 展现出强劲实力:

-

仿真标杆: 在 LIBERO、CALVIN 和 SimplerEnv 三大主流仿真评测中,超过了 30 种对比方法,均取得当前最优成绩(SOTA)。

-

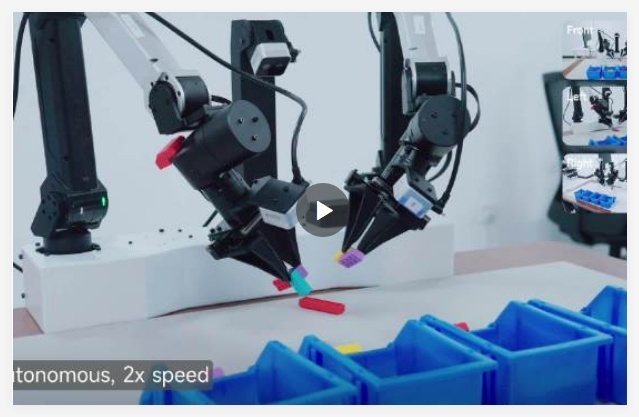

真机泛化: 在双臂机器人平台上,无论是拆装积木还是折叠柔软毛巾,模型都展现出极高的手眼协同与物理泛化能力。

开源生态

此次小米全面开放相关技术资源,包括

- 技术主页:https://xiaomi-robotics-0.github.io

- 开源代码:https://github.com/XiaomiRobotics/Xiaomi-Robotics-0

- 模型权重:https://huggingface.co/XiaomiRobotics

用户38505528 5个月前0

粘贴不了啊用户12648782 6个月前0

用法杂不对呢?yfarer 6个月前0

草稿id无法下载,是什么问题?