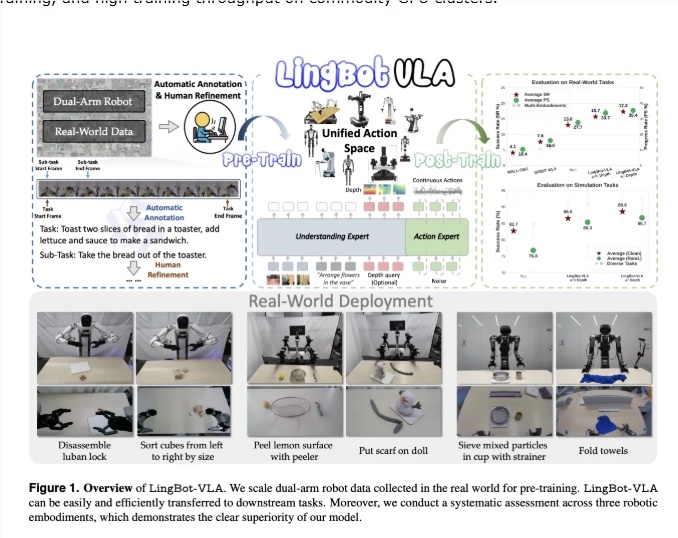

近日,蚂蚁集团发布了视觉-语言-动作(VLA)基础模型 LingBot-VLA。该模型面向真实世界的复杂机器人操控场景,依托大规模数据训练,在多种形态的机器人上实现了通用操控能力,标志着具身智能领域又迎来一次重要突破。

为打造这一模型,团队在 AgiBot G1、AgileX 等9类主流双臂平台上,累计采集约2万小时的真实遥操作数据。这些数据包含丰富的动作序列,并通过 Qwen3-VL 自动生成详尽的语言指令,构建出高质量的预训练数据集。

LingBot-VLA 采用创新的“混合 Transformer”架构。其以 Qwen2.5-VL 作为多模态骨干,能够同时理解多视角图像与自然语言指令;与此同时,内置的“动作专家”分支会结合机器人的自身状态,借助条件流匹配方法,输出平滑连续的控制轨迹,从而保障双臂协同的精准度。

针对传统方法在空间深度感知上的短板,蚂蚁集团引入了 LingBot-Depth 空间感知模型。通过特征蒸馏,LingBot-VLA 即便在部分传感数据缺失时,也能展现出强劲的 3D 空间推理能力,尤其在叠放、插入、折叠等精细操作中表现亮眼。

在包含 100 项现实挑战任务的 GM-100 基准上,集成深度感知的 LingBot-VLA 成功率达 17.30%,明显领先于 π0.5 和 GR00T N1.6 等同类模型。研究还显示,该模型具备非常高的数据效率,仅需约 80 条与任务相关的演示数据,即可快速适配至新的机器人平台。

目前,蚂蚁集团已将 LingBot-VLA 的完整训练工具链与模型权重开源。该工具链针对大规模 GPU 集群深度优化,训练吞吐量较主流框架提升约 1.5 至 2.8 倍。这一举措有望显著降低机器人大模型研发门槛,加速具身智能在更多实际场景中的落地。

论文:https://arxiv.org/pdf/2601.18692

用户38505528 5个月前0

粘贴不了啊用户12648782 6个月前0

用法杂不对呢?yfarer 6个月前0

草稿id无法下载,是什么问题?