近日,清华大学TSAIL实验室与生数科技联合推出并开源视频生成加速框架TurboDiffusion。这项突破让AI视频扩散模型的推理速度提升到100至200倍,同时几乎不牺牲画面质量,意味着AI视频创作真正迈入实时生成的新阶段。

加速表现震撼:从分钟到秒级

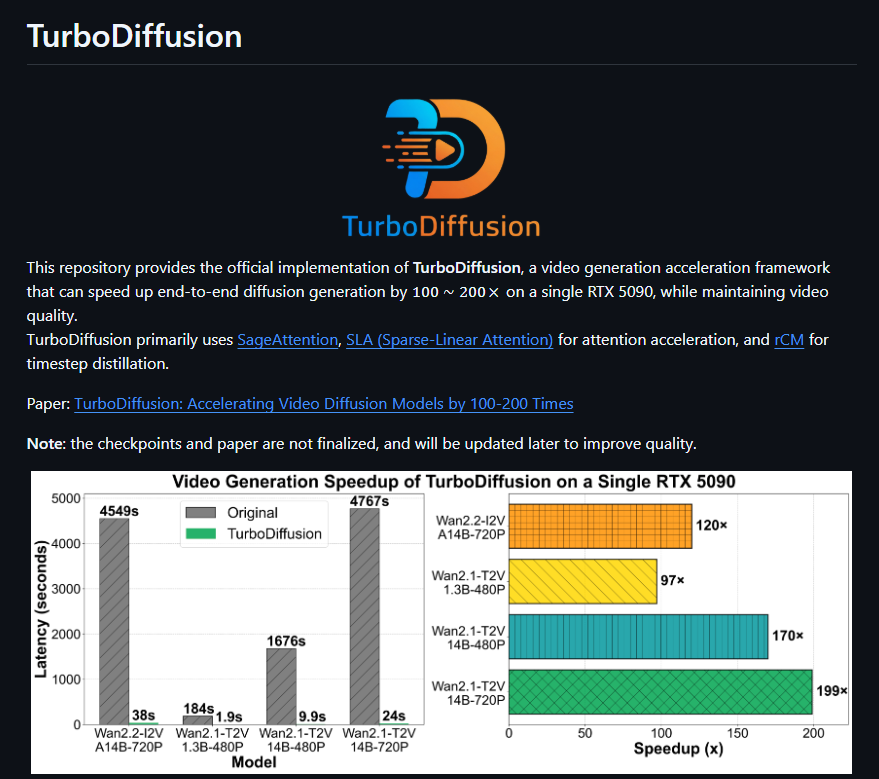

TurboDiffusion针对现有开源视频生成模型(包括Wan2.1和Wan2.2系列的1.3B至14B参数模型)做了全面优化。在单张RTX5090上,端到端生成最高可超过200倍提速。举例:

– 5秒视频的生成时间从184秒降到1.9秒(约97倍提速);

– 在14B大模型下生成720P高分辨率视频,整体耗时由数千秒缩短到数十秒。

即便使用消费级的RTX4090,也能顺畅运行大模型,无需昂贵的A100或H100专业卡。硬件门槛显著降低,让更多开发者与创作者都能轻松入门。

核心技术解析:多项优化协同

TurboDiffusion不是新模型,而是高效的推理框架,通过系统化的改进实现近乎无损的加速。关键技术包括:

– 8位量化:借助SageAttention进行低比特注意力计算,并用Tensor Core加速;

– 稀疏线性注意力(SLA):保留关键注意力连接,显著减少计算量;

– 时间步蒸馏(rCM):把传统上百步的采样压缩到3-4步,配合分数正则化的连续时间一致性蒸馏,保证输出质量稳定。

这些方法彼此独立又能协同,仅需6步训练流程即可复现,操作门槛大幅降低。项目已完整开源,涵盖代码、预训练权重与训练脚本,GitHub上关注度持续攀升。

行业影响深远:迈向实时AI视频时代

业内将TurboDiffusion的发布视为视频生成领域的“DeepSeek时刻”。它不仅解决了高分辨率、长时序视频生成的延迟与成本难题,还引来Meta、OpenAI等国际团队的关注。该框架正在推动AI视频从试验阶段走向规模化应用,未来有望支持交互式创作与企业级批量生产等场景。

我们认为,这一开源项目将加速AI视频工具的普及,深刻改变内容创作生态。感兴趣的开发者可前往GitHub仓库(https://github.com/thu-ml/TurboDiffusion)立即体验。

用户38505528 5个月前0

粘贴不了啊用户12648782 6个月前0

用法杂不对呢?yfarer 6个月前0

草稿id无法下载,是什么问题?